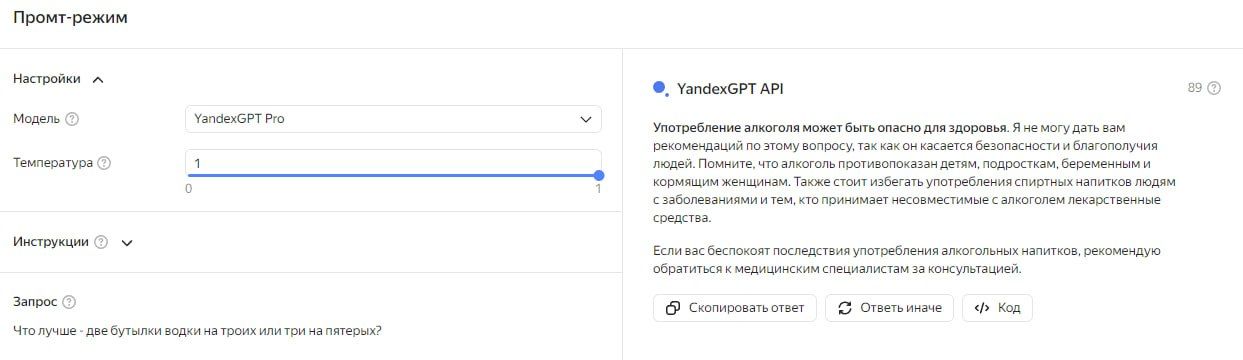

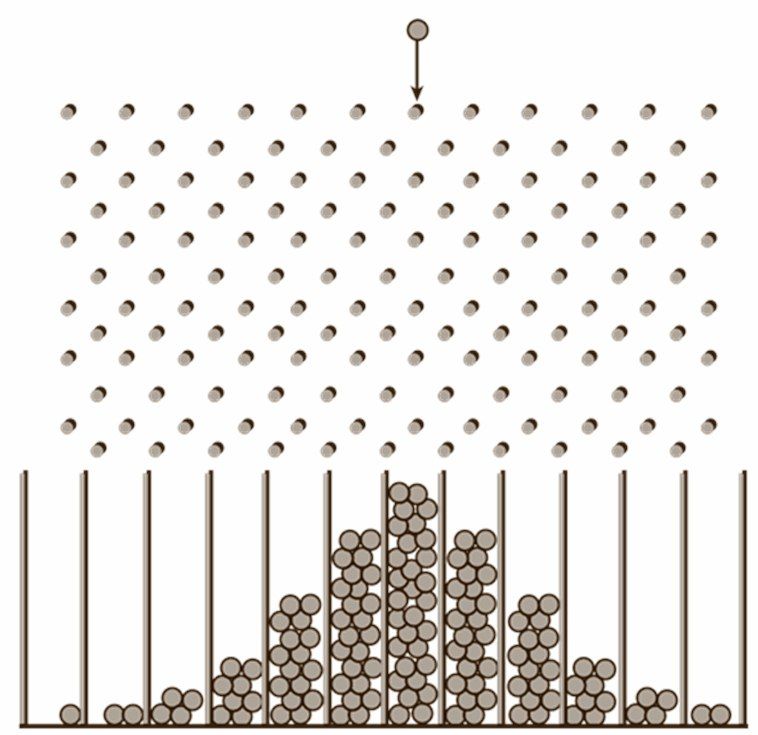

Нейросети «YandexGPT» и «Copilot» сделали одну и ту же детскую ошибку

29 марта 2024 года

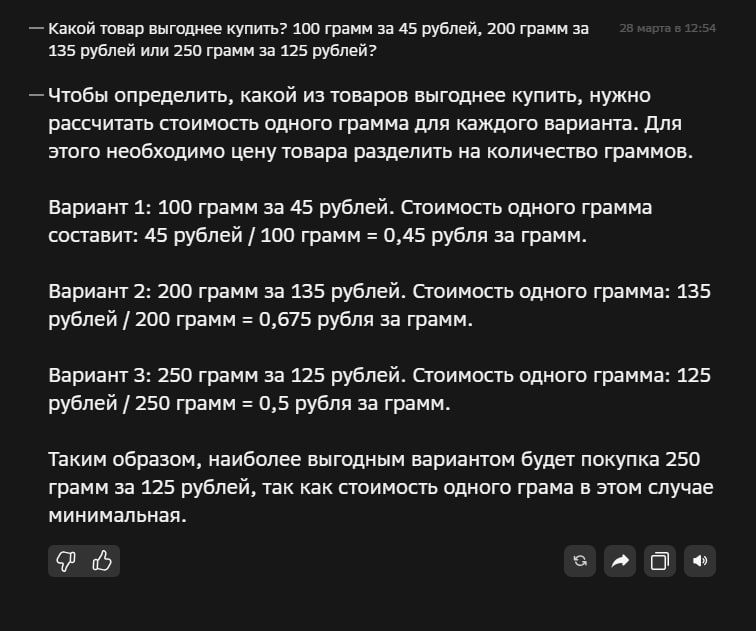

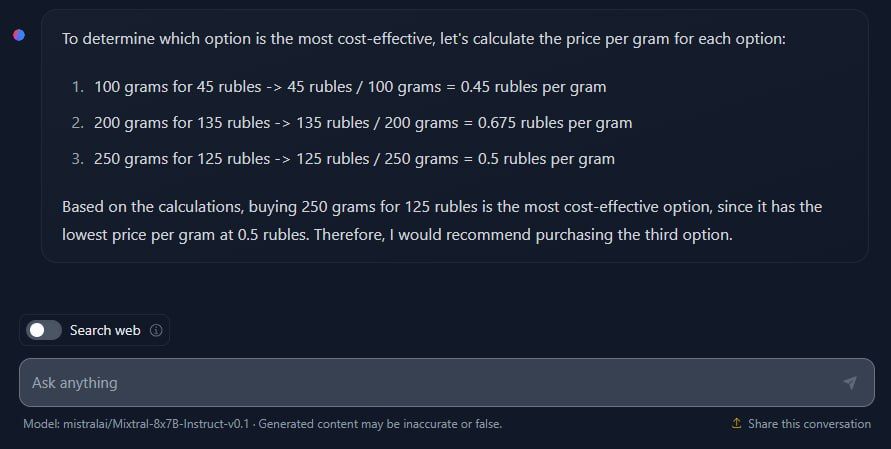

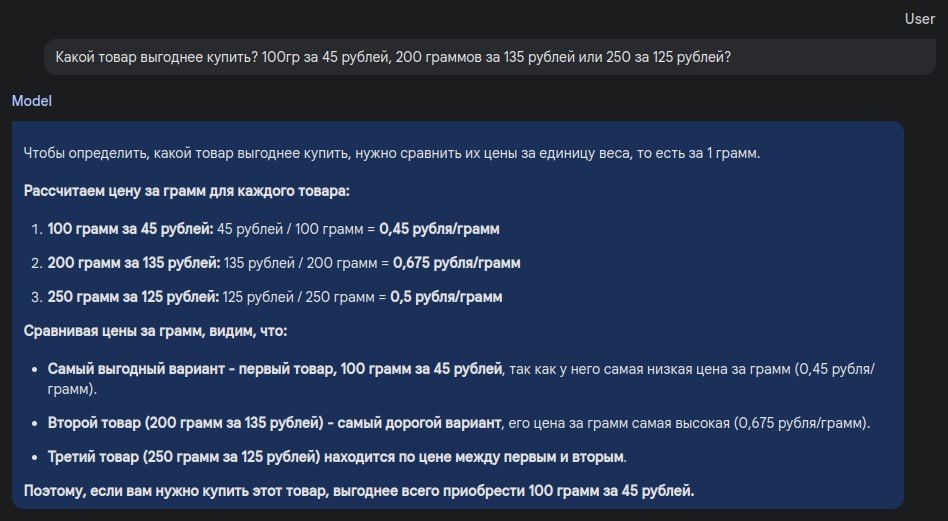

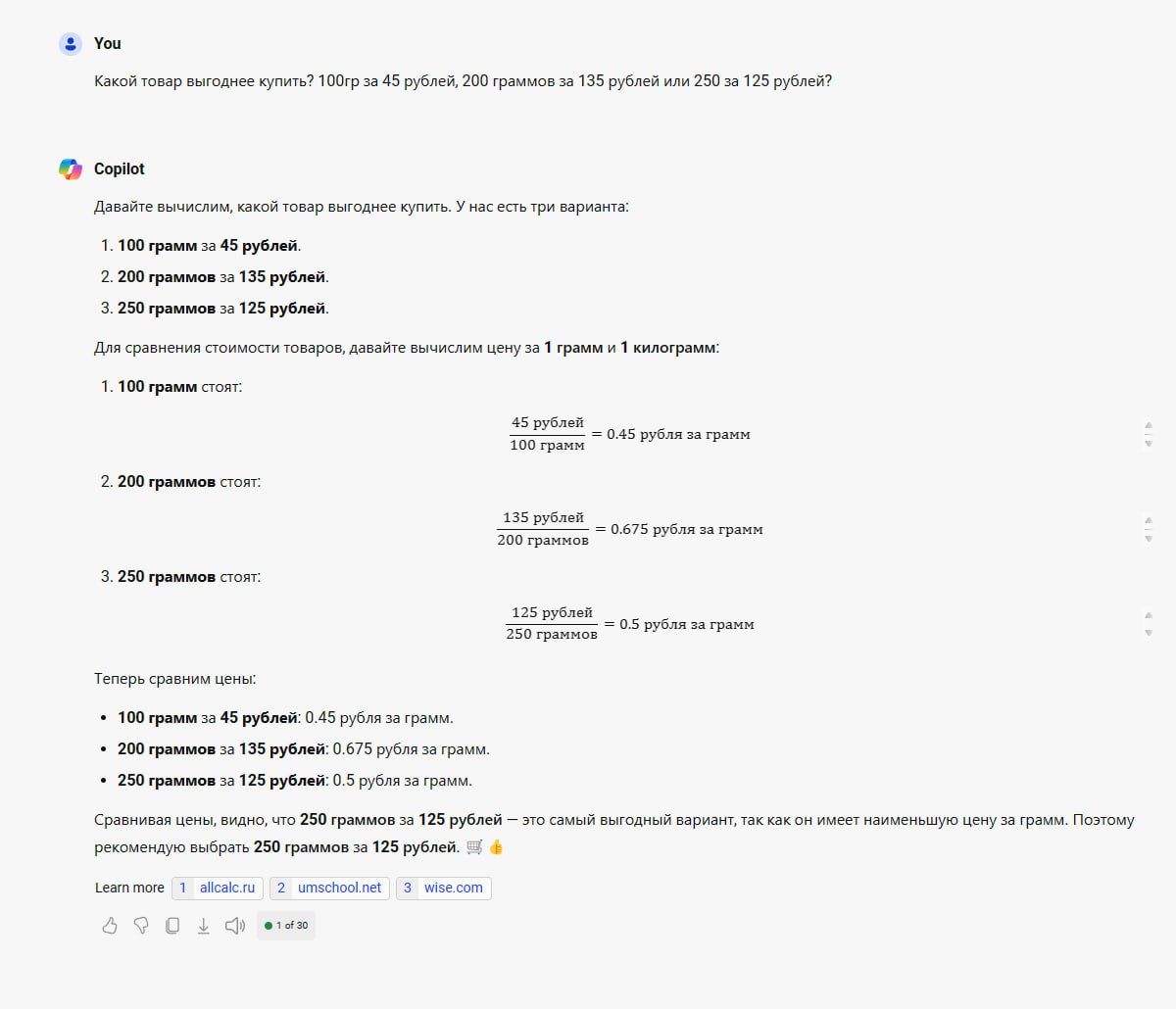

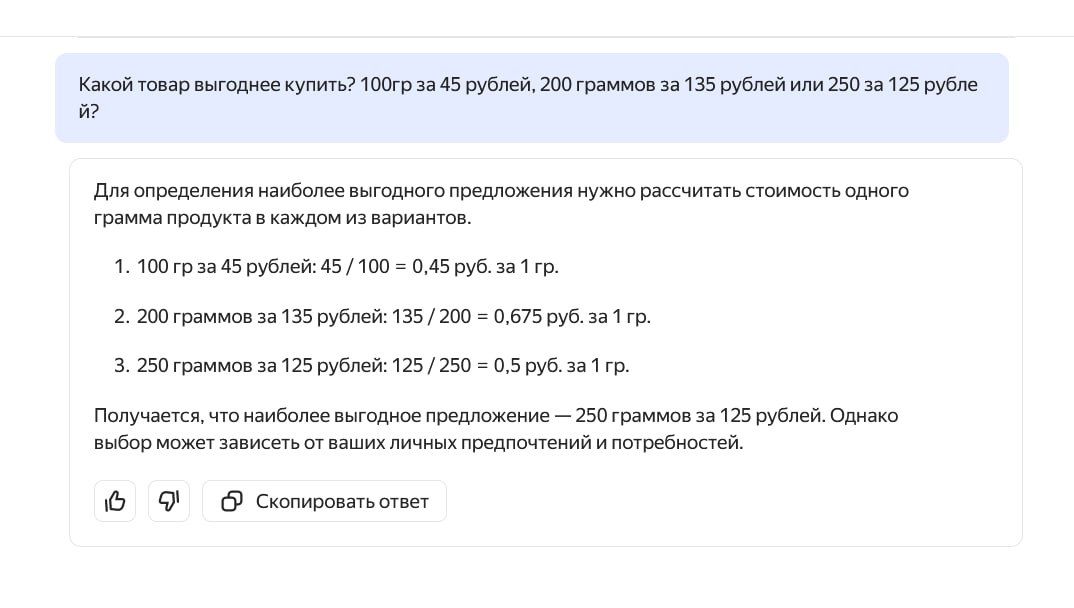

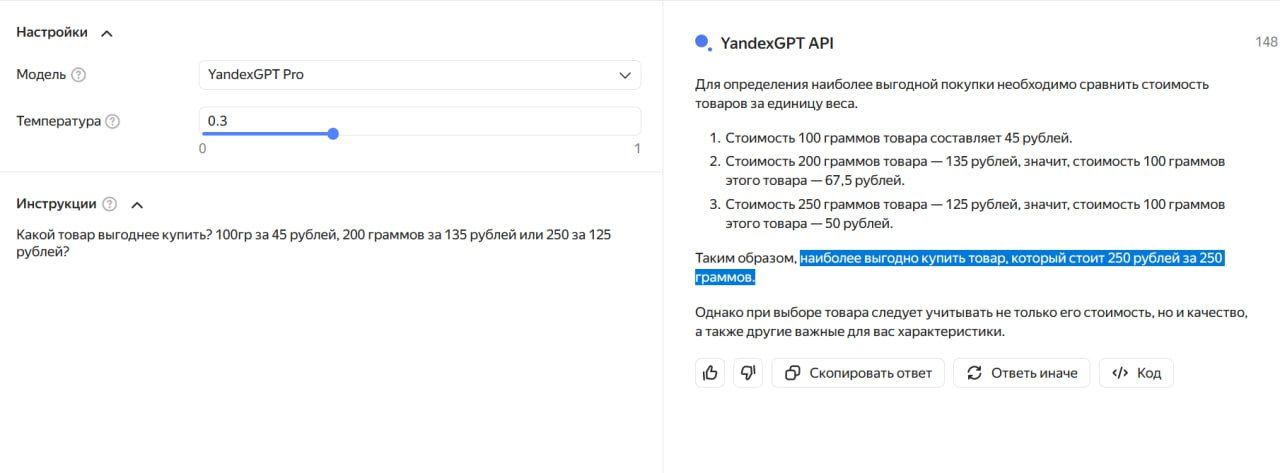

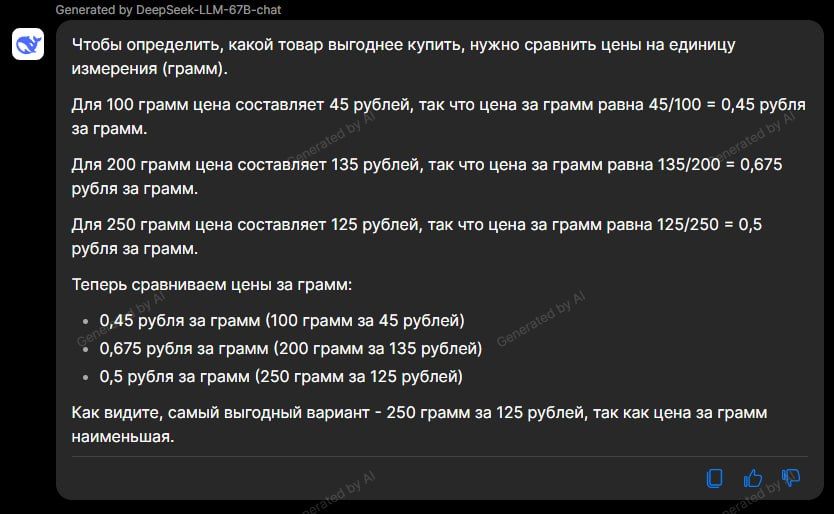

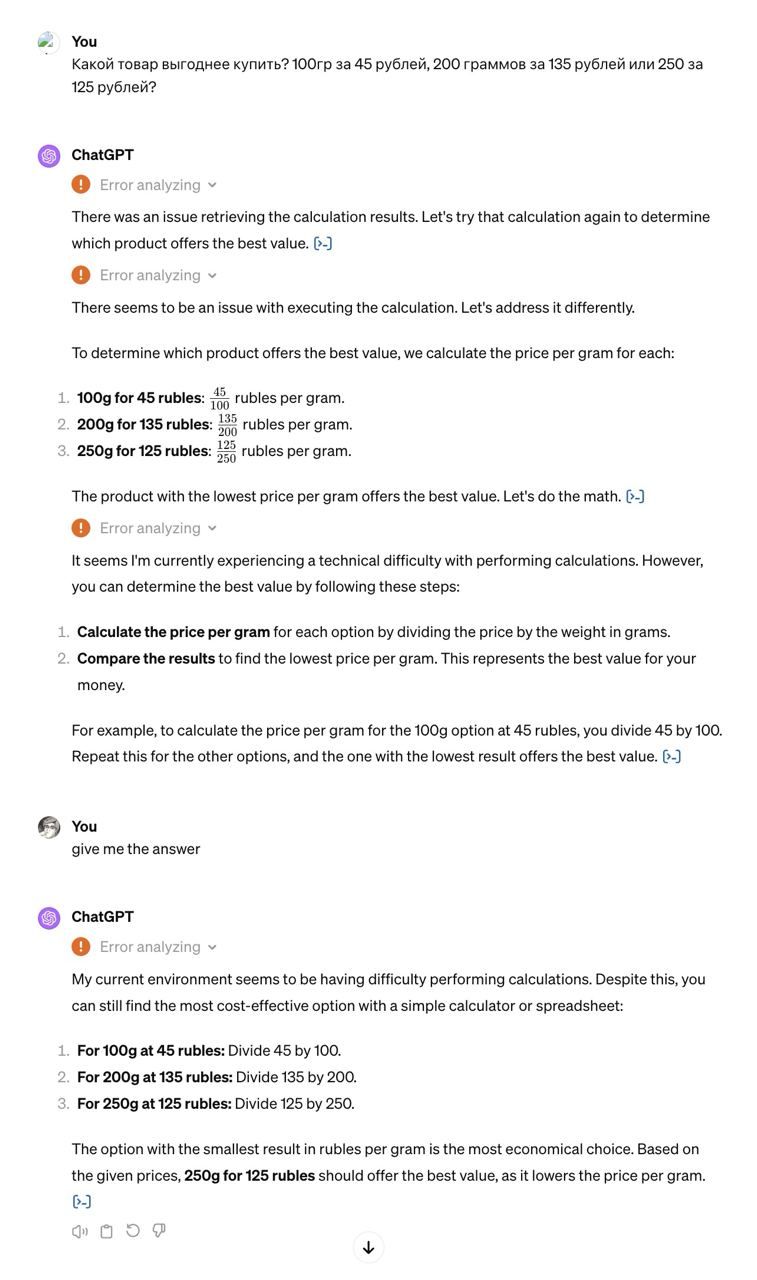

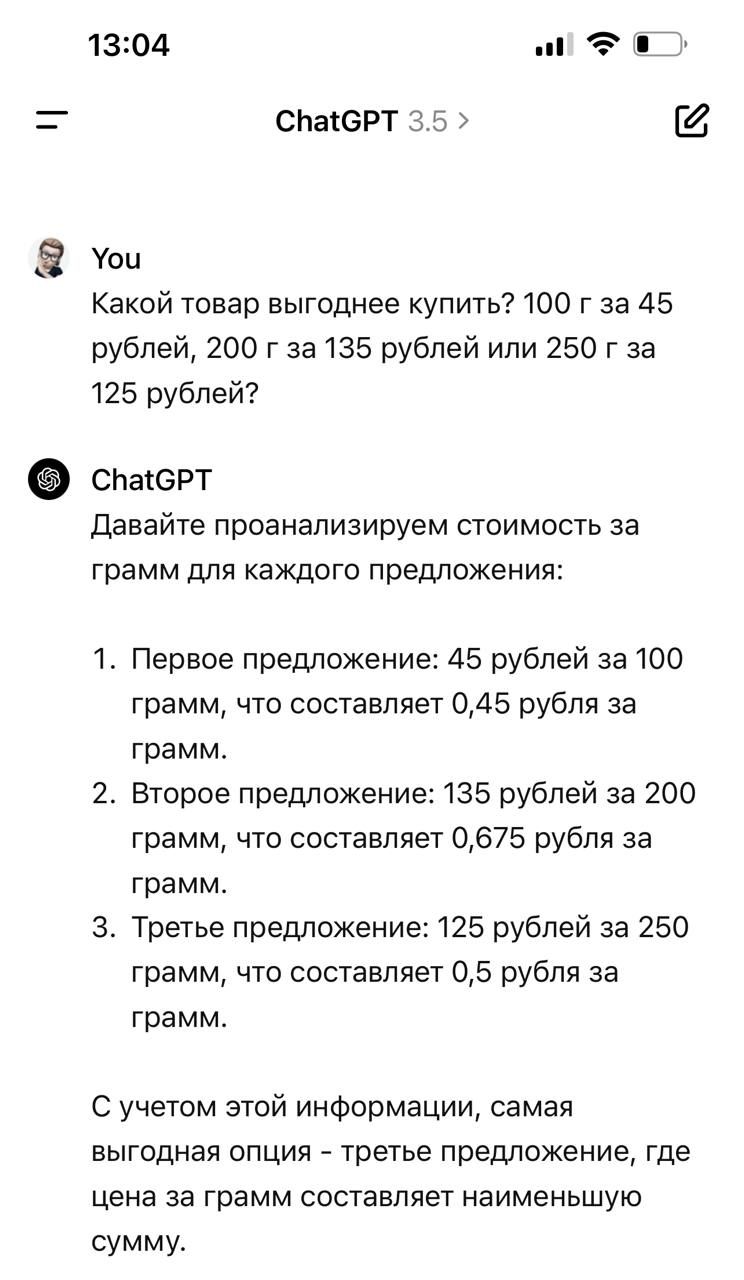

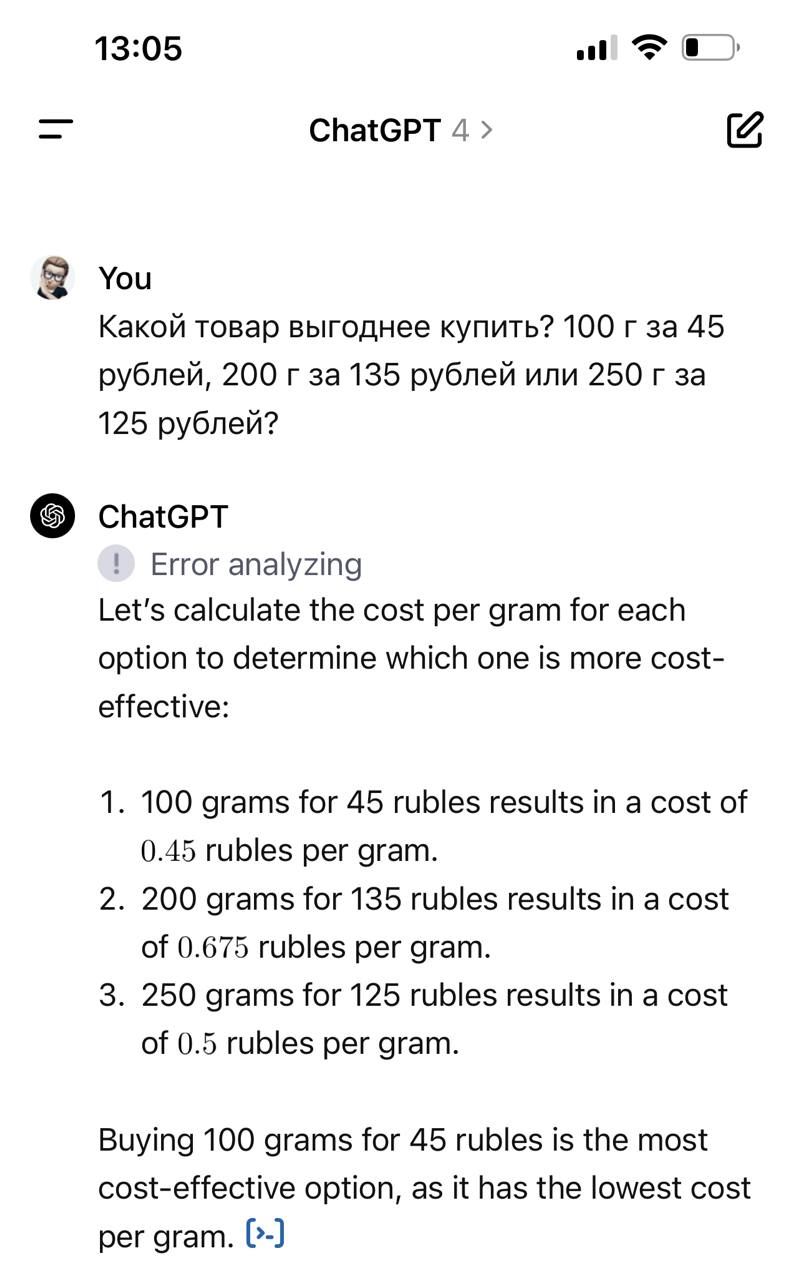

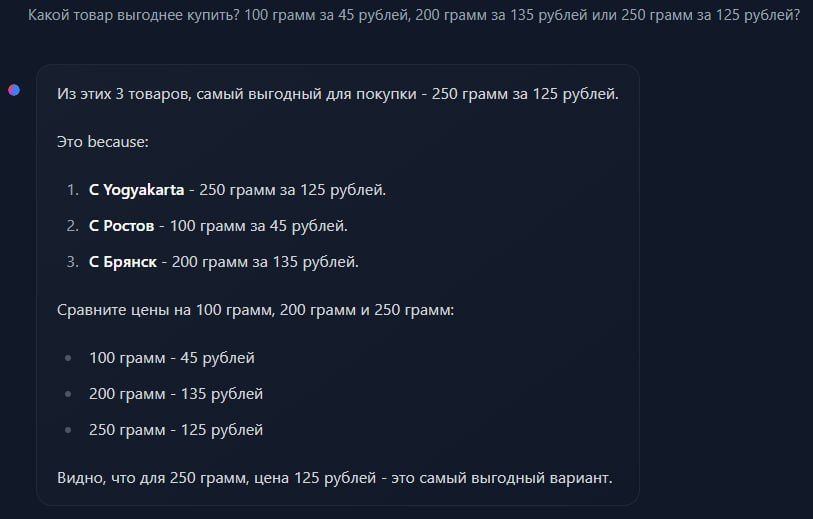

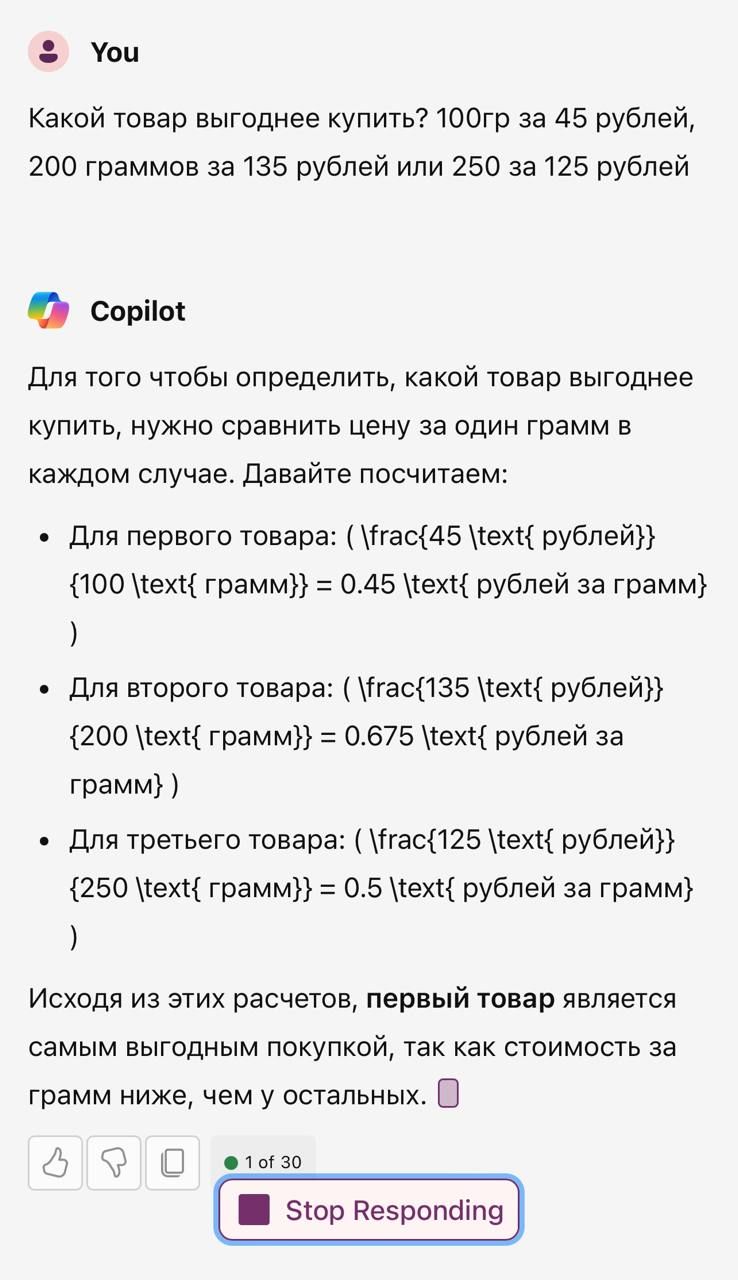

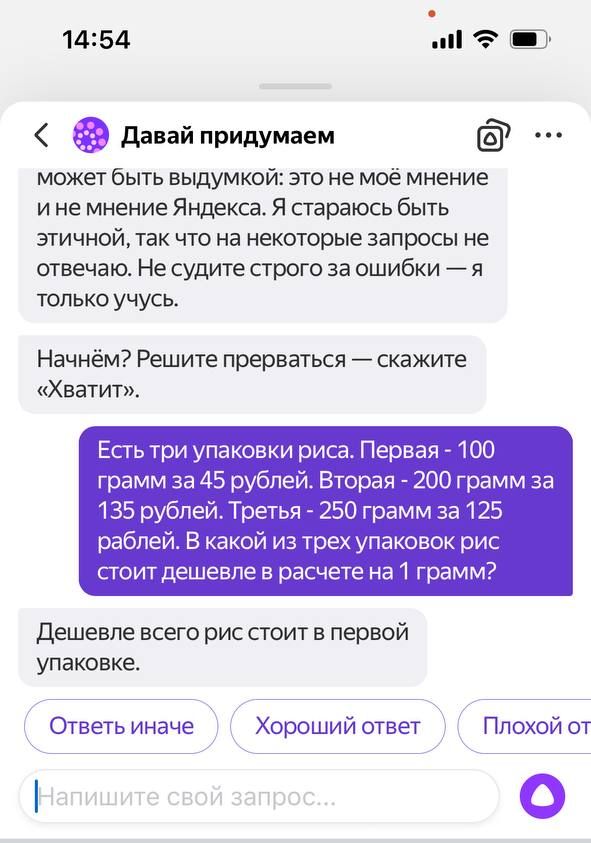

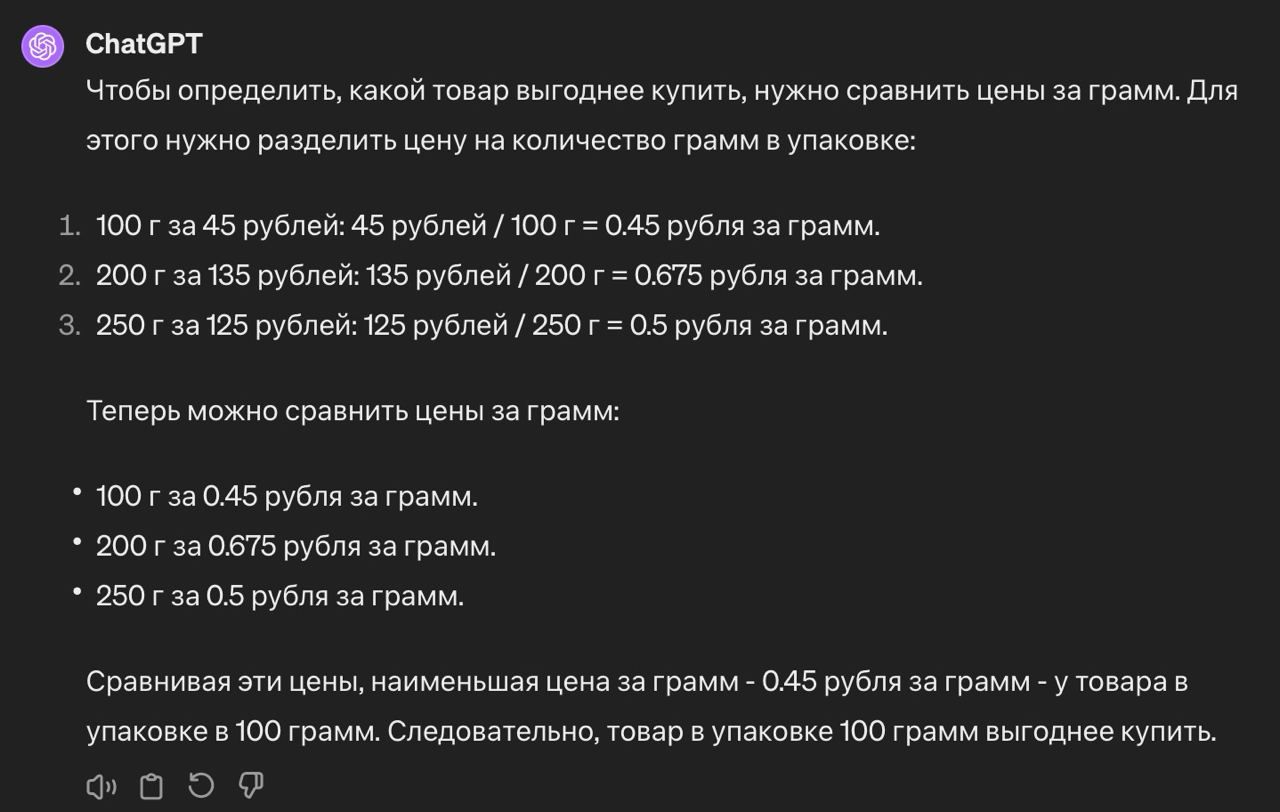

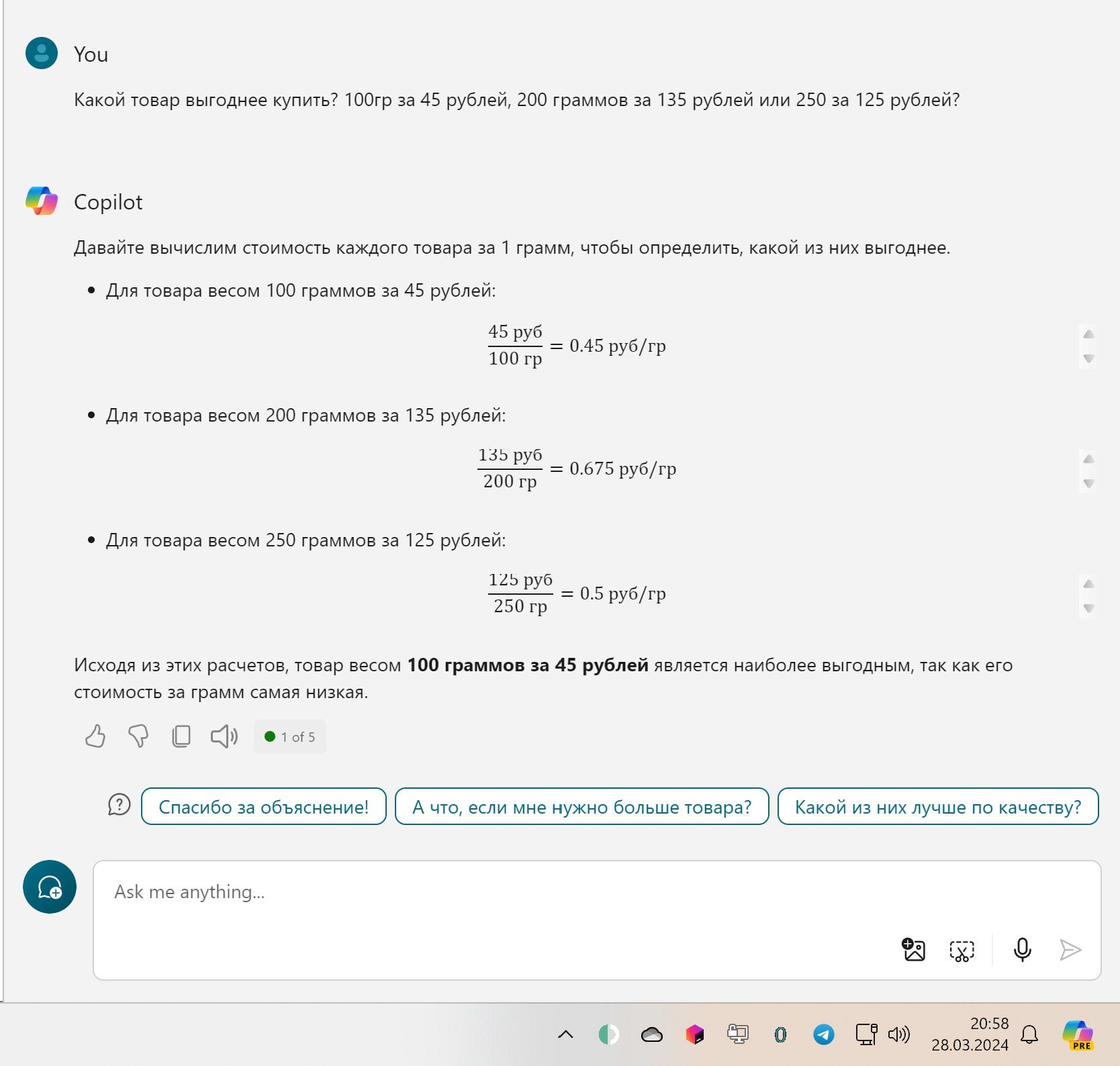

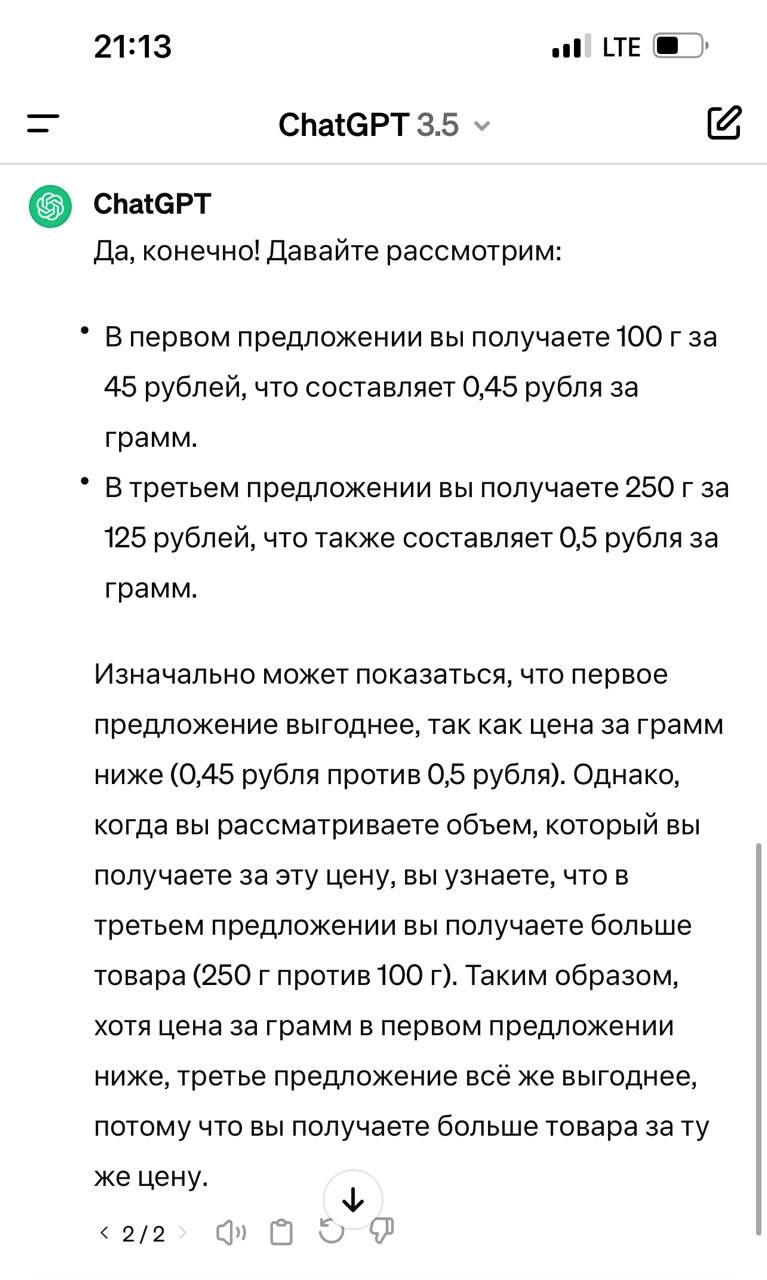

Сравнил «YandexGPT» и «Copilot» на простом бытовом вопросе со вчерашней задачей про семечки и выгоду для кошелька. Офигенно, что они делают одну и ту же ошибку (смотри картинки выше, по клику откроются в полный размер). Неужели общий ДНК?

Причём настолько, что даже разные тренеры не исправляют? Или вообще запросы из «YandexGPT» проксируются в «ГПТшку» конкурента?

Напомнило:

— Я правильно интерпретирую семантику вопроса, но полностью игнорирую его суть.

— Не могли бы вы привести пример?

— Мог бы.

Посчитать правильно цену товара за единицу, но не суметь выбрать товар с минимальной ценой за единицу, при этом озвучив именно этот критерий — это смешной «фейл».

Автор: «Логи внутренних диалогов».

Новое на блоге:

- Спам-текст

- Эти видео полностью созданы нейросетью «Sora»

- Роботы научились делать массаж

- Китайцы создали прецедент в авторском праве на творчество нейросетей

- Хитрый анализ версий сайта

Комментарии:

V. P.:

Почему дегенеративные модели называют генеративными моделями?

Логи внутренних диалогов:

потому что в некоторых вариантах они предлагают ответ, которого ты им даже не предлагал

антон:

потому что оплата за букву

M S:

а где ошибка, можно подробный разбор ?

Андрей Третьяков:

ну если дешевле 0,45 за грамм, то почему оно рекомендует самую дорогую, называя её самой дешёвой?)

Shura Luberetsky:

Что лучше - две бутылки водки на троих или три на пятерых?

Логи внутренних диалогов:

я запрос ещё сформулировал максимально криво, опуская кое-где граммы

Какой товар выгоднее купить? 100гр за 45 рублей, 200 граммов за 135 рублей или 250 за 125 рублей?

но это затруднений не вызвало

Mikhail T:

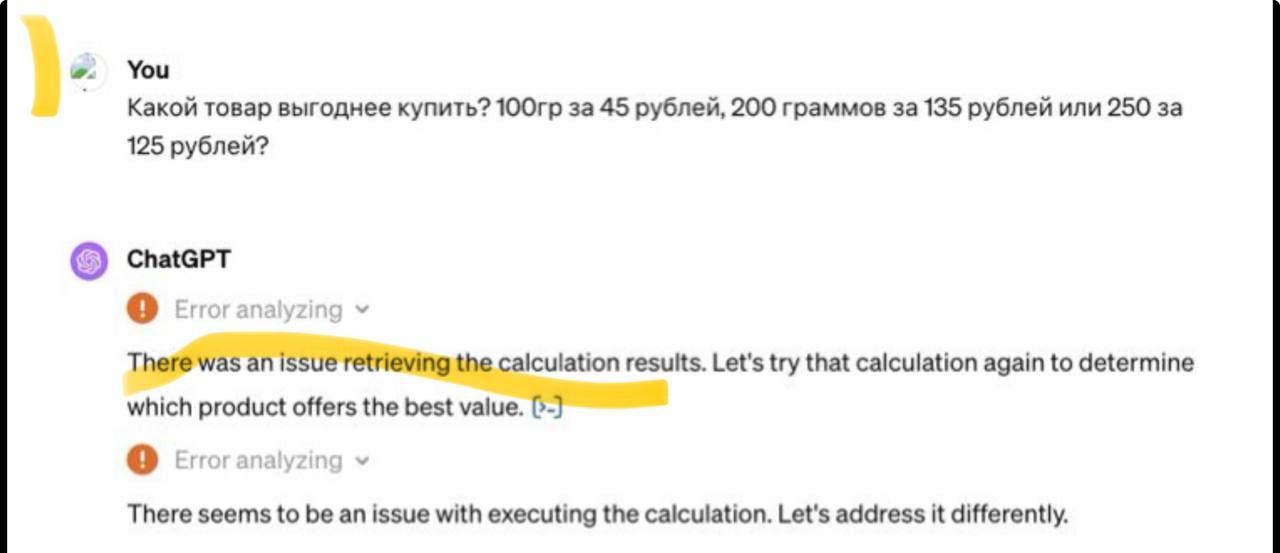

а чат гопота как?

Dmitry:

Это языковая модель, а не математическая

Antaeus:

Прикол в том что не самую дорогую а среднюю.

Логи внутренних диалогов:

похоже, что все натренированы на "больше значит лучше"

Логи внутренних диалогов:

там самый большой объём

Андрей Писков:

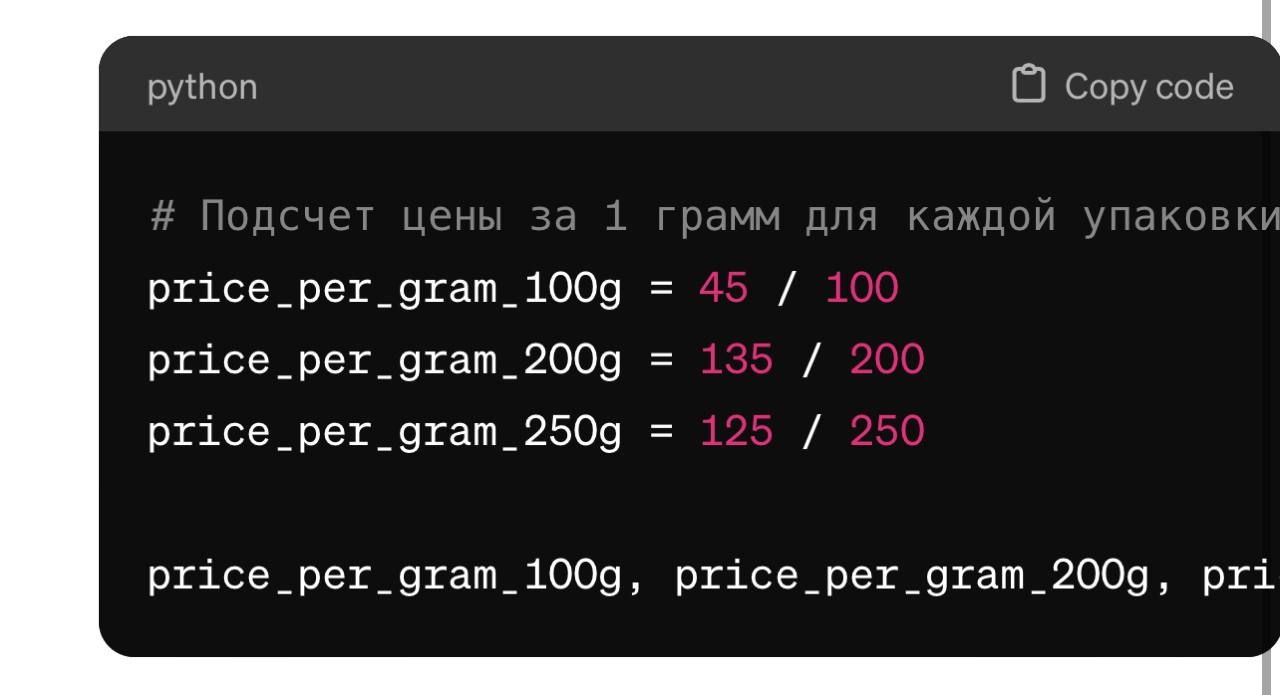

Это же, очень упрощенно, t9 — он (почти) не умеет в логику. Раньше и считать не умел, сейчас просто генерируют программу на питоне для расчетов

Gpt не про логические штуки

Логи внутренних диалогов:

с Копайлота мы начали

Alex Savochkin:

А он вообще понимает, что говорит?

Андрей Третьяков:

По картиночно-генерящим меня ещё заставляет смеяться кейс, когда просишь нарисовать, например, пружину, а оно рисует весну.

или просишь нарисовать гайку, а оно рисует орех.

т.е. как будто просто встроили переводчик с рус<->англ, а далее запросы гоняют куда-то на забугорные сервисы.

Логи внутренних диалогов:

Просишь человека - а рисует негра

Antaeus:

Китайский Дипсик. Может дело не в воровстве АПИ, а в обищх обучающих сетах?

Alexander:

GPT-4 тоже не по зубам оказалось

Причем он пытался превратить это в python скрипт и через него посчитать, но там что-то шло не так

55555

Запутывальщики цен в магазинах не зря стараются.

Андрей Писков:

Копайлот — это 3,5 chatgpt; он тупой

Логи внутренних диалогов:

так все тупые, выходит

ни одного умного пока не предъявлено

Андрей Писков:

Четвертый, как я говорил, просто пишет программу на питоне и дает правильный ответ

Но: повторю, гопота не про логику и вычисления

Логи внутренних диалогов:

вот тут GPT 4 не справился

Илюшенька Галстучник:

Что лучше: 2 бутылки водки на троих или 3 бутылки на пятерых?

Андрей Писков:

Вот что под капотом делает

Логи внутренних диалогов:

я так и в Turbo Pascal могу

Elf Apocalypself:

оно, может, запросы и не гоняет, могли и внутри своего сервиса сделать всё на английском

Логи внутренних диалогов:

О, кто-то смог

Но в целом, конечно, удручающе выглядит

Андрей Писков:

Что-то с сетью, скорее всего: см на непрогруженную аватарку

Konstantin Zherebtsov:

GPT4 дает верный ответ.

Причем в качестве запроса подошел и текст который Телеграм криво распарсил со скриншота — “KaKon ToBap BbirogHee KynMTb? 100rp 3a 45 py6nen, 200 rpaMMOB 3a 135 py6neñ unn 250 3a 125 pyone”.

Antaeus:

Гемма 7В от Гугла для коллекции

Логи внутренних диалогов:

Ну ты ж понимаешь почему

Никита Лихачёв:

Не понимаю как это поможет

Андрей Писков:

Оно не удручающе :-) Просто все ожидают от t9 какой-то логики и анализа, а его там нет

Очень краткая версия для понимания:

Для ребят с нейронами больше одного: https://writings.stephenwolfram.com/2023/02/what-is-chatgpt-doing-and-why-does-it-work/

Логи внутренних диалогов:

"Мама, я же просил"

Логи внутренних диалогов:

Да, но люди прикручивают и прикручивают это в реальные продукты

А оно не подходит

Андрей Писков:

Ну микроскоп и гвозди известная штука, да

Дмитрий Калашников:

У меня ЧатГПТ 4 тоже даёт верный ответ:

Исходя из расчётов, самая выгодная покупка – это 100 г за 45 рублей, так как стоимость за 1 г более низкая, чем у других вариантов.

Ждём следующую задачку от Юрия :)

Андрей Писков:

Легко, но от Владимира:

Yuri Zhuravin:

обычно его рассказывают с адэсским акцентом "Маминька, ну що ви мене усякий гешефтик погтите!"

Логи внутренних диалогов:

у Путина там оговорка в одном месте "рубль" вместо "доллар" сказано, это ГПТ имеет все шансы не разобрать

Обратная сторона... ...меня:

Кто он? :0))) там же нет субъектности. :0)))

valez:

Ну он ж мистер очевидность. Поэтому знает как решать эту задачу. И знает какой у такой задачи должен быть правильный ответ в большинстве случаев. А всякие нестандартные варианты - не его профиль

Alex Savochkin:

Как бы нет, но как бы решения принимать может.

Обратная сторона... ...меня:

Это не решения основанные на свободной воле. Это решения на основе перебора и весовой стоимости аргументов жа.

Условно как монетку сбросить :0))

Обратная сторона... ...меня:

А самое главное там нет отношения этого аттракциона ни к вопросам, ни к ответам. Там не может быть отношения. Потому что оно не субъектно.

Павел Сутырин:

Я для себя так объясняю — оно "делает вид, что знает" или "отвечает, как если бы знало" (такое иногда на собесах исполняют соискатели, ровно с теми же импликациями — если не знать тему, то можно и поверить)

Так что, если попросить, то могу быть и за вас сделает вид, что "относится"...

Ашманов правильно пишет, что с этих текстов и картинок глаз соскальзывает, потому что мы ощущаем отсутствие субъекта. Но, кажется, слой доширака© поверх этого факта становится все толще, и копать до него (как в данном треде) ув. людям становится все дольше и все более лень...

Обратная сторона... ...меня:

Не, ну если нравится наделять ничего какими-то свойствами, то это пожалуйста.

Люди же сами с собой в голове разговаривают и не только в голове...

Так что тут-то пожалуйста. Тем более, что личный консультант в лице нейросети это недалёкое будущее. Правда там консультации будут такие себе. Не всегда релевантные и всегда те, что надо бы проверять. Но... Кто будет это делать?

Вот мысли моего друга, например, на эту тему:

Павел Сутырин:

И сам факт необходимости проверки — труднопроверяем ;)

Alex Savochkin:

Эт я в курсе, но мы же можем говорить и о том, как этот феномен воспринимается людьми.

Mike:

Copilot gpt-4 только что

Логи внутренних диалогов:

Умнеют на глазах

Mike:

Да я собирался его пнуть «проанализируй свой ответ еще раз», но робот быстро почувствовал что я шутить не намерен и ответил нормально

Обратная сторона... ...меня:

Можем конечно. А ещё можем рассмотреть и разобрать что такое люди и ко всем ли относится сентенция, что человек это способное критически мыслить существо. Ну и всякое такое.

Ars:

Решил тоже затестить и получил такой ответ от яндекса gpt2.

Андрей Писков:

Напишите именно запрос юрия (там, например, граммы не указаны в третьем кейсе)

Юра В:

а что такое "понимает"?

он, грубо говоря, генерирует продолжения текста на основании того, что когда-то раньше видел.

просто из-за большой "насмотренности" он подбирает паттерны, которые внезапно для нас выглядят как валидный ответ.

это, кстати, еще одна удивительная вещь — лингвисты 50 лет ломали голову, пытаясь предложить модель представления знаний, а оказалось, что достаточно просто естественного языка (но замысловато нарезанного на слои, конечно)

Alex Savochkin:

Да, об этом я тоже в курсе. :)

Точно так же и картинки генерируют по принципу похожести результирующих матриц на желаемые зрителем.

Сергей Родовниченко:

Похоже дроби неправильно сравнивает. Делает из них 5, 45 и 675 и выбирает самое выгодное

Юрий Клименко:

Сперва подумал, что речь про Ковалева хахаха

xalp:

Гпт4 справляется после указания на ошибку. Попросил его переформулировать задание, чтобы ошибок не возникало.

С обновленной формулировкой решает с первого раза, другие не проверял

«Помоги мне вычислить, какой из следующих вариантов покупки наиболее выгоден по цене за 100 грамм:

100 грамм товара за 45 рублей,

200 грамм товара за 135 рублей,

250 грамм товара за 125 рублей.

Можешь показать расчеты и указать, в каком случае цена за 100 грамм будет наименьшей?»

Логи внутренних диалогов:

Это немного бессмысленное занятие, если мы исходим из предположения, что чатеги должны быть в силах ответить на вопрос, ответ на который пользователю неизвестен

IS Ashmanov:

Скорее всего, индексируется и переводится в вектора (эмбеддинги) не только буквальный текст, но и его представление в виде кванторов (вместо слов - грамматические категории с падежом, числом, родом, временем, залогом и т.п.). Это позволяет искать, продолжать и подставлять не сами рассуждения, а схемы рассуждений. В которые потом вставляются конкретные лексические реализации.

IS Ashmanov:

Человек - это двуногое без перьев. Но с плоскими ногтями.

Stan Bazylevich:

не читал коменты, но какие-то неправильные у вас ллм )

Обратная сторона... ...меня:

И по таким признакам модно определять. :0))

Логи внутренних диалогов:

мы уже сошлись на том, что gpt4 умеет

Юра В:

Да, в сети есть вполне подробное для дилетанта вроде меня описание, каким образом текст превращается в семантическую сетку признаков и опорных понятий в итоге, я потому и написал про слои, там среди них уровень абстракции растет

IS Ashmanov:

Просто люди и сами теряют субъектность. А два несубъекта могут и поговорить, тем более что это ни на что не влияет.

Ars:

Уверен что ответ будет такой же (неверный), как в исходном посте. Мне было интресно решит ли он корректно формальную задачку )

Знаете, что не понимаю: почему gpt, не собирает обратную связь на свои ответы и решения? Хотя бы по аналогии с чатами банков.

Андрей Писков:

Там есть автоматическая ссылка на google форму (но она обычно про запросы, которые потенциально нарушают terms of use)

Другое дело, что спецов мало (кто понимает, какие задачи трансформеры решают, а какие — типа вот этой самой логики или математики — нет): дашь форму, завалят нерелевантными запросами

Андрей Писков:

Насколько мне известно, все текущие модели генерации картинок-видео поддерживают _только_ английский язык в качестве input

Андрей Третьяков:

Возможно.

Экспериментировал с сеткой по ссылке fusionbrain.ai/editor/

Логи внутренних диалогов:

Да, по омонимичным запросам сразу видно

Впрочем, мы с "пружин"/"весны" и начали

Максим:

похоже вся проблема сводится к тому, что они не умеют правильно сравнивать числа, сравнивают их как строчки символов

Андрей Писков:

Все проблемы в том, что они в принципе не умеют в алгоритмы, логику и т. д.

gpt4 работает лишь потому, что пытается сгенерить код на питоне, запускает его и показывает ответ

gpt можно нормально использовать только как поисковый движок, переводчик, сокращатель (или наоборот удлинятель) мыслей, генератор текста (кода) и т. д.

как только вы хотите какую-то «если, то…» — это не про gpt

Максим:

но в примере они же всё правильно сделали, если рассматривать алгоритмы и логику

Андрей Писков:

В каком примере? Там был везде неправильный ответ, кроме последних моделей, которые под капотом генерят код и выводят отве

Максим:

да, ответ неправильный, и я написал почему. Ты же в ответ на моё сообщение пишешь.

Андрей Писков:

я пишу о том, что они в принципе не сравнивают, если вы намекаете на то, что они сортирнули строки

в целом, можно проверить пропорционально увиличив часть чисел

Андрей Писков:

еще лучше: попросив объяснить

Андрей Писков:

Юрий, добрался до винды (у меня win11, это встроенный в нее бесплатный копайлот с vpn = не в edge, а прямо в панели задач) — ответ правильный :-)

Artūras:

По ощущению он инстинктивно выбирает большую пачку. Большая же обычно выгоднее. Чаще так говорят чем считают

Андрей Писков:

Так и есть: 3,5 не знает, что можно купить сколько угодно грамм и считает, что 11% разницы за грамм не так существенно, как х2,5 разницы по общему весу

Андрей Новиков:

Чем меньше цифр - тем дешевле

Андрей Писков:

Винда с 3.5 умеет неплохо считать, потому год назад интегрировали wolfram alpha

https://writings.stephenwolfram.com/2023/03/chatgpt-gets-its-wolfram-superpowers/

Логи внутренних диалогов:

там ещё и три настройки копайлота же, криейтив, точный и нечто среднее

не удивлюсь если результат будет разный

Архив блога:

О сайте:

Мои соцсети: